O consumo de dados no mundo atinge proporções inimagináveis. Estudos dos maiores fabricantes de equipamentos para TI sinalizam para a triplicação do volume em 2021, em relação a 2016. A demanda por data centers, portanto, só tende a crescer. Por outro lado, o crescimento levará a um aumento substancial do consumo energético, forçando o desenvolvimento de sistemas e tecnologias de menor impacto ambiental.

O crescimento de ferramentas como a Internet das Coisas (IoT – Internet of Things) e o anúncio da evolução da internet móvel para o 5G fortalecerá a chamada edge computing (computação de borda, numa tradução literal), ou computação distribuída, aproximando a armazenagem dos pontos de acesso. “O Brasil ainda vive um excelente momento para os data centers conhecidos como hyperscale, figurando como um dos mercados mais promissores do mundo para esse tipo de aplicação; porém, a transformação digital, com o advento do IoT e as demandas por provedores de internet, fazem com o que o edge computing ganhe cada vez mais força e relevância, trazendo as aplicações de data centers cada vez mais próximas ao usuário final, de forma descentralizada”, afirma José Sérgio Ribeiro, gerente de aplicações e vendas da Vertiv.

Marcos Santamaria Alves Corrêa, da Innovative, especializada nesse tipo de instalação, concorda: “a tendência é no sentido de uma expansão maior das médias e pequenas instalações de data centers, ficando as grandes instalações mais restritas aos provedores de serviços.”

Não é uma questão irrelevante. “Instalações de menor porte geralmente buscam sistemas integrados, que envolvem gerenciamento de energia, distribuição e ar condicionado em um só ambiente, seja ele um rack incorporado ou um contêiner, em soluções que são comumente denominadas Smart. O edge computing vem exigindo cada vez mais esse tipo de aplicação integrada, pois a construção de uma infraestrutura crítica completa demanda muitos recursos”, explica Ribeiro.

- José Sérgio Ribeiro, Vertiv

- Marcos Santamaria Alves Corrêa, Innovative

- Francisco Dantas, Interplan

Olhando de outro ângulo, Francisco Dantas, consultor e diretor da Interplan Planejamento Térmico Integrado, aposta na tendência de “grandes instalações centralizadas com foco na eficiência energética, na mitigação de impactos ambientais e, para favorecer isso, em localizações geográficas escolhidas a partir das potencialidades do clima para emprego majoritário, senão integral, de processos naturais de climatização. Os avanços na produção de processadores, admitindo temperaturas mais altas de operação e adotando resfriamento a água para os servidores, em combinação com o processo de resfriamento a ar, viabiliza a elevação das temperaturas do meio de resfriamento e, por consequência, amplia as oportunidades de utilização de processos naturais de resfriamento.”

Confiabilidade da operação e parâmetros de projeto

Independente das dimensões, é inegável que a preocupação primeira é a confiabilidade da operação. “A preocupação central ao projetar uma instalação de data center é a confiabilidade do sistema com disponibilidade de equipamentos e sistemas redundantes, seja para possibilitar paradas para manutenção sem afetar a climatização dos ambientes atendidos por estes equipamentos e sistemas que operam em regime ininterrupto de 24 horas em 7 dias por semana, seja no caso de falha de um equipamento ou sistema. Uma segunda preocupação cada vez mais relevante é com a eficiência energética do sistema de climatização, que é o principal responsável pelo consumo de energia do data center, se desconsideramos o consumo dos próprios servidores de TI”, explica Alves Corrêa.

Neste sentido, como diz Leonardo Martinho Dobrianskyj, coordenador de vendas da Daikin, “um produto de alta confiabilidade com baixas taxas de parada, com sistemas inteligentes de partida rápida e com baixo consumo energético é o sonho de todo data center. Os projetos de instalações de data center devem ter como premissa o mais alto padrão de qualidade, pois, falamos de um negócio em que as multas ocorrem por minuto de parada, assim sendo é extremamente recomendável utilizar as melhores tecnologias disponíveis no mercado, a fim de garantir uma operação confiável e de baixo consumo energético; as soluções padrões de mercado estão longe de atenderem todas as características que este tipo de instalação exige.”

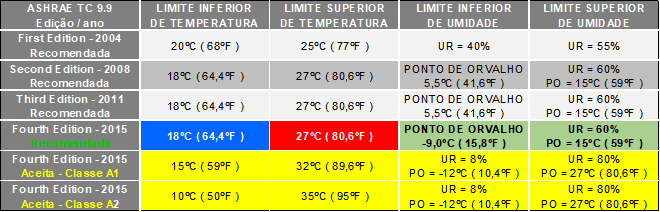

“A principal referência para projetos de data centers é o TC 9.9 da ASHRAE Thermal Guidelines for Data Processing Environments. A primeira edição deste guia é de 2004, tendo passado por atualizações em 2008, 2011 e 2015. Nele são especificadas as temperaturas e umidades recomendadas e admissíveis para o ar de entrada nos servidores de TI (ver tabela 1). Nota-se que o guia não faz referência a temperatura ambiente, pois, como as boas práticas recomendam, a segregação do ar de entrada dos servidores em corredores frios, e o ar de expurgo destes servidores em corredores quentes, não há uma temperatura ambiente a ser definida”, esclarece Alves Corrêa.

Tabela 1: Evolução do Ashrae TC 9.9

O engenheiro da Innovative, explica que a maior evolução nos limites psicrométricos recomendados para o ar de entrada nos servidores aconteceu nos limites de umidade, “que hoje são muito maiores, especialmente no que se refere ao limite inferior, que a partir de 2015 passou a ser de – 9,0ºC (negativos) de ponto de orvalho, de tal forma que, a não ser nas poucas localidades do mundo onde a temperatura de ponto de orvalho pode cair abaixo deste valor, não existe mais a necessidade de sistemas de umidificação para novos data centers. Como no Brasil não temos registros de temperaturas de ponto de orvalho abaixo de – 9,0ºC (negativos), não há mais razão para instalarmos equipamentos com sistemas de umidificação. Por outro lado, aqui a nossa maior preocupação é com o limite de umidade relativa alta de 60%, especialmente quando a temperatura nos corredores frios estiver abaixo de 20ºC, pois, isto significa termos um ponto de orvalho para o ar de entrada nos servidores abaixo de 12ºC.”

“O mais importante é frisar que quem deve determinar estes índices são os fabricantes dos servidores, uma vez que as condições ambientais devem ser ótimas para o bom funcionamento dos equipamentos de TI; inclusive, a ASHRAE mantém neste comitê um grande número de representantes destas empresas. A temperatura recomendada é de 18°C a 27°C na entrada do servidor e uma umidade de -9°C de ponto de orvalho a 15°C de ponto de orvalho com 60% de umidade relativa. O fato de se permitir até 27°C de temperatura na entrada dos servidores, abriu espaço para diversas técnicas para ganhos de eficiência energética em data centers, dando destaque principalmente para o confinamento de corredores, que nada mais é do que a estratégia de se segregar a parte fria dos racks de TI da parte quente. Essa estratégia eleva consideravelmente a temperatura de retorno para os sistemas de ar-condicionado, que por sua vez podem trabalhar com temperaturas de insuflamento bem mais altas, abrindo espaço para a aplicação de tecnologias free cooling. Para se ter uma ideia, diversas aplicações no Brasil já trabalham com água gelada próxima dos 20°C, graças ao confinamento de corredores, trazendo ganhos em eficiência energética extraordinários, abrindo uma excelente oportunidade para sistemas de free cooling indireto”, completa Ribeiro, da Vertiv.

Possibilidades para a eficiência energética

A escolha do tipo de sistema a ser instalado, se expansão direta ou indireta, condensação a ar ou a água, entre outras alternativas, como em qualquer outro tipo de instalação deverá estar atrelada a um estudo de eficiência energética. Ou, como simplifica Alves Corrêa, “assim como ocorre com instalações de conforto, sistemas de menor capacidade normalmente são de expansão direta e sistemas de maior capacidade de expansão indireta.”

Ribeiro diz que data centers são ambientes com elevada carga térmica, o que abre espaço para se trabalhar com sistemas com expansão indireta mesmo em aplicações tidas como de pequeno porte. Por outro lado, ele considera que os sistemas com condensação a água em grandes data centers estão em desuso devido à escassez e o alto custo da água. “No Brasil é crescente o número de data centers que utilizam sistemas de expansão indireta com free cooling indireto, muito em virtude do aumento da temperatura de água gelada em que estes ambientes estão inseridos. Mais de 10.000 TR de chillers a ar com free cooling incorporado já foram instalados no Brasil desde 2016”, enfatiza.

Entretanto, Alves Corrêa chama a atenção para o fato de que a adoção de sistemas de expansão direta ou indireta irá depender tanto do tamanho da instalação como de sua densidade de carga e criticidade. “Sistemas de expansão indireta são mais recomendáveis para data centers de maior porte, ou maior densidade e criticidade da instalação, pois permitem a adoção de tanques de termoacumulação para suprir a climatização no período de falta de energia desde a interrupção no fornecimento até a entrada em operação dos geradores”, afirma.

“O sistema de condensação a ser adotado pode ser tanto de condensação a água como de condensação a ar dependendo de várias características do projeto. No caso de instalação de pequenos data centers em andares de prédios comerciais, utiliza-se sistemas de expansão direta com condensação a água, pois a distância e o desnível entre as unidades evaporadoras e condensadoras inviabilizam um sistema de condensação a ar. Por outro lado, instalações de grande porte que antigamente eram feitas exclusivamente com sistemas de condensação a água por conta da maior eficiências dos chillers com compressores centrífugos, atualmente estão migrando para sistemas de condensação a ar por conta da acentuada evolução na eficiência energética ocorrida nos chillers de condensação a ar”, completa Alves Corrêa.

Dantas, da Interplan, acrescenta outros argumentos: “Os sistemas de servidores arrefecidos a água, não só majoram a eficiência energética em razão das elevadas temperaturas de resfriamento admitidas e da redução mássica e volumétrica do fluido térmico de transporte do calor, como, também, reduzem as potências requeridas de unidades de tratamento de ar e, por consequência, reduzem espaços de condução de fluxos de ar e de áreas ocupadas com componentes do ‘objetivo meio’, preservando os espaços da construção para ocupação pelo ‘objetivo fim’”.

Dantas assume a defesa do conceito de configuração ar-água, em alternativa ao tradicional processo todo-ar, “já consagrado para instalações de climatização destinadas a conforto térmico, com reduções do consumo de energia superiores a 40%.” Segundo o consultor da Interplan, o advento dos servidores com arrefecimento a água viabiliza a extensão dos processos ar-água aos sistemas destinados a data centers.

- Leonardo Martinho Dobrianskyj, Daikin

- Mauricio Salomão Rodrigues, Somar

“Considerando que a água é levada até o local de geração da carga térmica e, com isso, utiliza-se um processo com 3.700 vezes maior potencialidade de condução do calor, se comparado a um sistema todo-ar com volume equivalente de circulação. Os sistemas de resfriamento a ar operam bem para processadores que demandam até 150 W. A evolução dos processadores levou a demandas de até 320 W. A utilização de materiais de melhor qualidade na fabricação dos processadores admite mais altas temperaturas de operação, e a adoção dos modelos de fluxo de ar corredores frios x corredores quentes, em substituição à insuflação de teto, permite taxas de vazões de ar proporcionalmente menores. Além do mais, a combinação do resfriamento com a totalidade, ou a maior parte da carga térmica gerada sendo lançada diretamente na água de arrefecimento, ao invés de transferi-la totalmente para o ar do ambiente, evita a majoração da potência de ventiladores nos racks e de unidades tradicionais de climatização por processo todo-ar, passando o combate à carga térmica total produzida a ser feita por três procedimentos distintos: a) resfriamento a ar da parcela transmitida para o ar do ambiente através de unidades de climatização tradicionais; b) resfriamento indireto para a água através de trocadores de calor ar-água localizados no interior dos racks; e, c) resfriamento direto para a água através de trocadores de calor do tipo placa fria, acoplados aos racks. O resfriamento por líquido pode eliminar a necessidade de racks adicionais, criando maior densidade de servidores no data center e usando menos espaço”, defende Dantas.

Recomendações para o balanceamento dos sistemas

De acordo com Maurício Salomão Rodrigues, diretor da Somar Engenharia, as instalações de AVAC que operam com sistemas de água gelada, atendendo sistemas de data centers, possuem algumas características que as distinguem de instalações para conforto.

1.São caracteristicamente horizontais, possuem anéis ou linhas de tubos horizontais que caminham por corredores técnicos ou casas de máquinas onde estão instalados os condicionadores de ar. Estes anéis ou linhas chegam a ter o comprimento de 300 ou 400 metros em alguns casos (por linha ou anel);

- Cada casa de máquinas que atende um ambiente que opera uma missão crítica deve ter redundância de (equipamento) condicionador de ar e de alimentação de água gelada. A redundância para alimentação de água gelada se traduz em uma configuração tipo anel (é possível alimentar o condicionador pelos dois lados do anel) ou por linhas redundantes (duas tubulações de água gelada – linhas A e B), neste caso, se a linha A é operante e falhar, a linha B assume a alimentação de água gelada. A redundância de equipamentos se traduz em equipamentos reserva, instalados ao lado dos equipamentos operantes nas casas de máquinas;

- Estas instalações operam com insuflamento através de plenum de piso elevado e corredores frios e quentes, sendo que o ar entra por cima do condicionador e sai por baixo diretamente no piso elevado. Estas salas não possuem nenhuma rede de distribuição de ar, sendo que o plenum de insuflamento e a distribuição de placas perfuradas são os responsáveis por distribuir o ar pelos corredores frios;

- A carga térmica dos equipamentos de data center é caracteristicamente sensível (não existe carga latente nestes ambientes).

Uma das últimas etapas do processo de montagem de uma instalação de água gelada é o enchimento da tubulação e sua limpeza. Em uma instalação de conforto, tubulação tipicamente vertical, o enchimento é mais fácil (as bolhas de ar sobem), a limpeza também é mais simples, pois a sujeira fica concentrada na parte inferior da tubulação que pode ser retirada por drenagens localizadas; por consequência seu processo de limpeza é mais rápido. Este processo deve ser feito por recirculação de água na tubulação e retirada dos filtros tipo “Y”, até que os filtros permaneçam limpos após um tempo de recirculação.

Em uma instalação de data center, que possui uma tubulação horizontal e muito longa, é de se presumir que teremos a sujeira distribuída por toda a tubulação, visto que a gravidade não favorece a concentração dos detritos e sujeira em uma parte específica, como no caso anterior. A limpeza desta tubulação deve ser feita por recirculação da água arrastando os detritos e sujeira até os filtros tipo “Y”.

Ocorre que a velocidade da água nos anéis e nas linhas é menor do que a velocidade da água na tubulação de um edifício de conforto, isto se deve ao fato de que o diâmetro do anel é constante em toda a sua extensão, sendo que a velocidade de água vai diminuindo à medida que os condicionadores de ar são alimentados. Como a velocidade da água é menor, seu poder de arrastar os detritos e sujeira também é menor, portanto, o processo de limpeza deste tipo de tubulação é mais complexo do que em instalações de conforto. Recomenda-se a utilização de filtros temporários e a instalação de dispositivos temporários de by-pass para auxiliar nesta esta etapa do processo.

Em alguns casos ocorre de interligar-se, por engano, os tubos no condicionador de ar de forma invertida. Caso este engano não seja detectado antes da etapa do enchimento e limpeza da tubulação, os danos ao equipamento podem ser catastróficos, pois, neste caso, o filtro tipo “Y” ficaria na tubulação de saída do condicionador e, assim, toda a sujeira e detritos entrariam pela tubulação de retorno do condicionador, alojando-se na serpentina do equipamento.

Vencidas as etapas de enchimento e limpeza da tubulação, inicia-se o processo de balanceamento da rede de distribuição de água gelada. Neste ponto cabe um alerta, nunca iniciar o processo de balanceamento antes de certificar que a tubulação está limpa e que os filtros dos condicionadores de ar não estão sendo saturados por sujeira e detritos. Caso a tubulação ainda contenha sujeira, os filtros ficarão saturados e atrapalharão o processo de ajuste e equilíbrio de vazões, invalidando o trabalho de balanceamento.

Em função de se tratar de uma rede de distribuição de água gelada mais complexa, composta de anéis, linhas e equipamentos redundantes, como bombas, válvulas etc., deve-se fazer um planejamento considerando os seguintes itens:

1.O equilíbrio da rede será feito com todos os consumidores de água gelada operando ou somente os equipamentos operantes e com os equipamentos redundantes fechados?

2.O equilíbrio do anel será ajustado com a vazão nominal dos condicionadores ou com a vazão nominal do anel (a vazão nominal do anel é menor do que a soma das vazões dos condicionadores atendidos pelo anel ou linha)?

3.Se somente os operantes estarão abertos e os redundantes fechados, quais serão os redundantes que estarão fechados?

4.Os anéis serão fechados em algum ponto específico buscando a maior perda de carga possível do anel, ou operarão totalmente abertos?

5.No caso de sistemas atendidos por duas linhas (A e B), este será balanceado com a linha A e verificado com a linha B, ou as duas linhas operarão simultaneamente atendendo aos condicionadores de ar?

Todas as questões acima implicam diretamente no valor do set point do anel secundário, responsável por controlar a capacidade (rotação ou pressão) das bombas que alimentam estes anéis ou linhas. Este valor de set point será responsável pelo bom desempenho da instalação e pelo alto ou baixo consumo de energia desta instalação.

Todas estas questões devem ser discutidas com a equipe de concepção de projeto e definidas com a equipe de operação da planta, para que os conceitos do projeto e da operação comecem a ser absorvidos pelo time de operação.